人工智能学习pyTorch的ResNet残差模块示例详解

目录

- 1.定义ResNet残差模块

- ①各层的定义

- ②前向传播

- 2.ResNet18的实现

- ①各层的定义

- ②前向传播

- 3.测试ResNet18

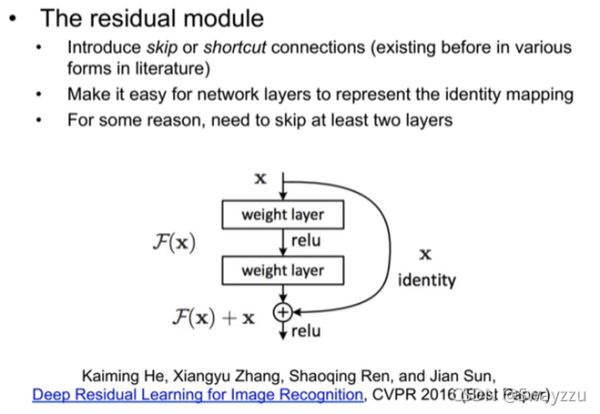

1.定义ResNet残差模块

一个block中,有两个卷积层,之后的输出还要和输入进行相加。因此一个block的前向流程如下:

输入x→卷积层→数据标准化→ReLU→卷积层→数据标准化→数据和x相加→ReLU→输出out

中间加上了数据的标准化(通过nn.BatchNorm2d实现),可以使得效果更好一些。

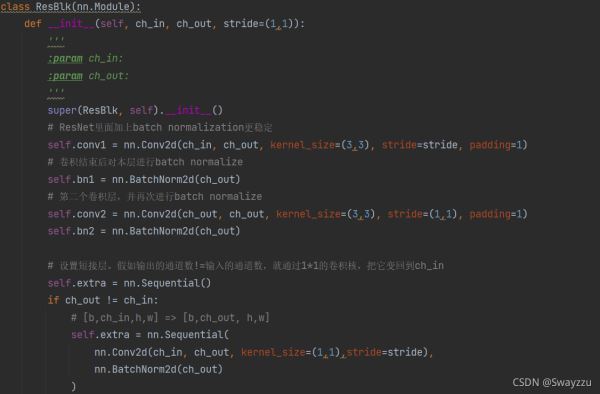

①各层的定义

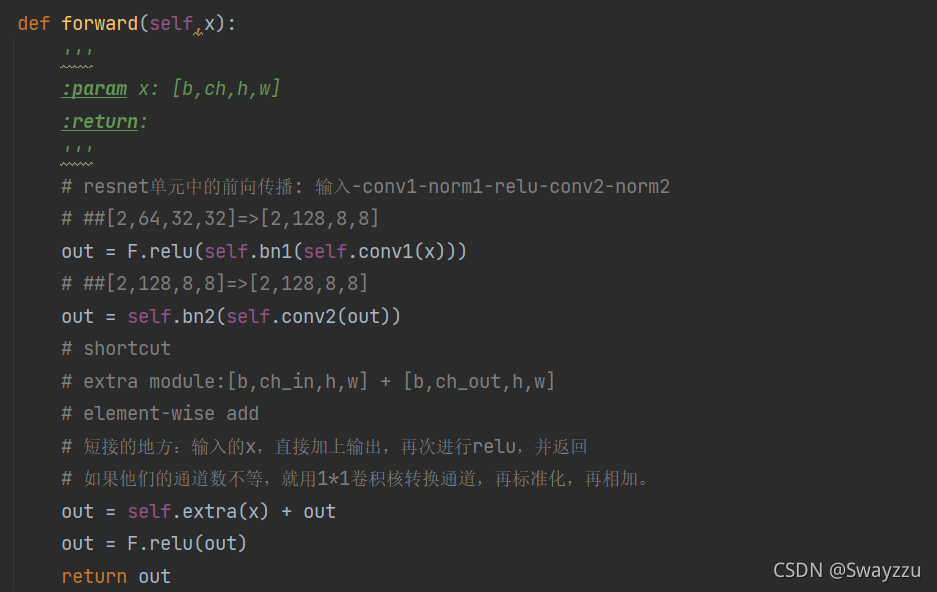

②前向传播

在前向传播中输入x,过程中根据前向流程,调用上面定义的层即可。

如此,便定义好了一个残差的模块。

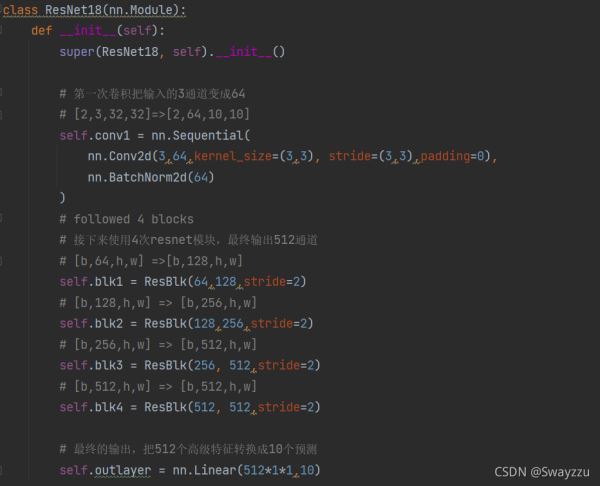

2.ResNet18的实现

此处的ResNet18并没有涉及到太多细节,只是一个大致的内容。

在初始化的时候,定义好所需要使用的模块,根据上面定义好的残差模块,调用即可。在这里使用了4次残差模块,将通道数从输入的3(也就是RGB),变成了512通道。也就是最终提取的高级特征。提取完特征,直接输入给Linear方法,得到图片在10种图片类型上的结果,用于预测以及损失值的求解。

①各层的定义

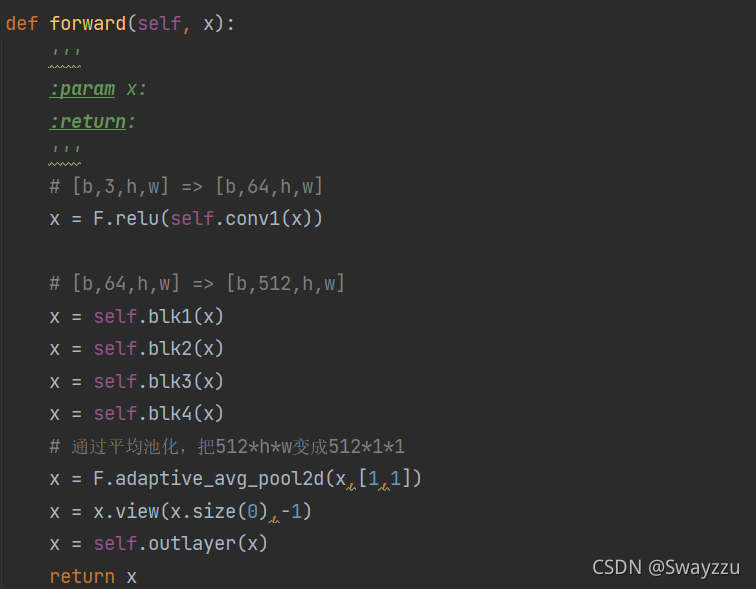

②前向传播

同样的,调用上面定义好的层,根据流程传播即可。

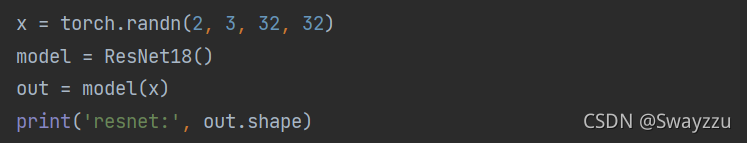

3.测试ResNet18

如下图,输入的是2张图,RGB,长宽均是32的数据。

通过ResNet18之后,输出的是2张图,每张图对应10种类型的不同取值logits。

过程中的通道数目的转换如下面的结果所示:3→64→128→256→512→512

过程中的尺寸转换,根据设置的卷积核,以及步长,会有不同的结果。但总体都是为了得到更高级的特征,最终输入全连层,得到Logits。

以上就是人工智能学习pyTorch的ResNet残差模块示例详解的详细内容,更多关于PyTorch人工智能学习ResNet残差模块的资料请关注hwidc其它相关文章!

【本文由:http://www.nextecloud.cn/flb.html提供,感谢】