快速部署 Scrapy项目scrapyd的详细流程

快速部署 Scrapy项目 scrapyd

给服务端 install scrapyd

pip install scrapyd -i https://pypi.tuna.tsinghua.edu.cn/simple

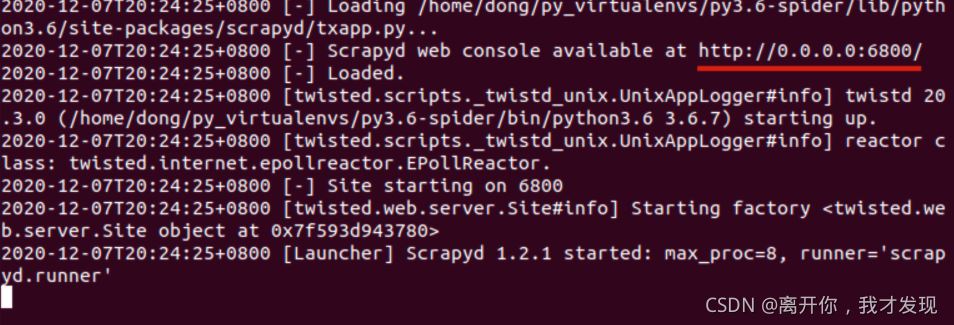

运行

scrapyd

修改配置项 , 以便远程访问

使用Ctrl +c 停止 上一步的运行的scrapyd

在要运行scrapyd 命令的路径下,新建文件scrapyd.cnf 文件

输入以下内容

[scrapyd]

# 网页和Json服务监听的IP地址,默认为127.0.0.1(只有改成0.0.0.0 才能在别的电脑上能够访问scrapyd运行之后的服务器)

bind_address = 0.0.0.0

# 监听的端口,默认为6800

http_port = 6800

# 是否打开debug模式,默认为off

debug = off

在客户端 install scrapyd-client

1. 安装 scrapy-client 命令如下

pip install scrapyd-client -i https://pypi.tuna.tsinghua.edu.cn/simple

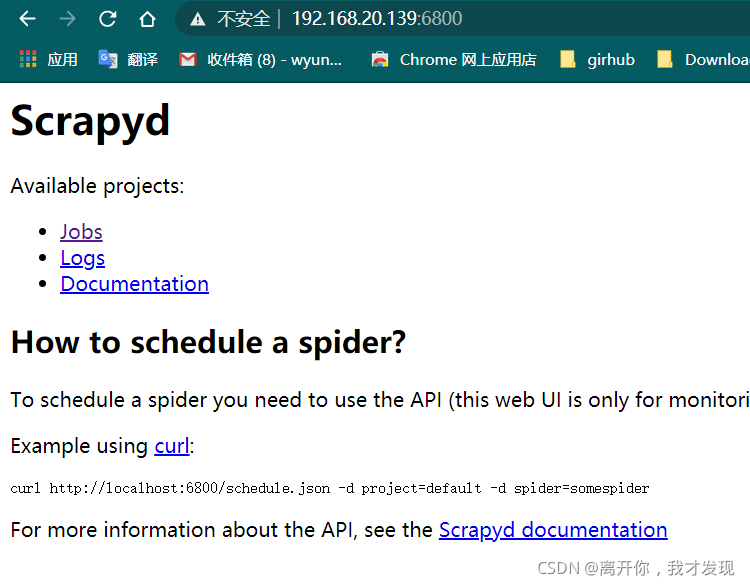

配置Scrapy 项目

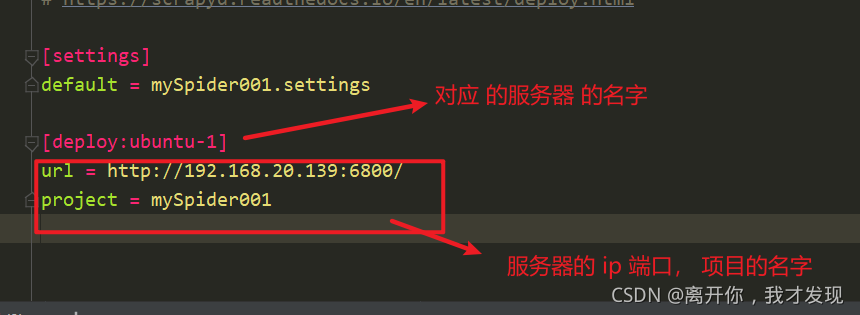

修改 scrapy.cfg 文件

1 检查配置

scrapyd-deploay -l

发布scrapy项目到scrapyd所在的服务器(此时爬虫未运行)

# scrapyd-deploy <target> -p <project> --version <version> # taget : 就是前面配置文件里的deploy后面的的target名字,例如 ubuntu1 # project: 可以随意定义, 建议与 scrapy 爬虫项目名相同 # version: 自定义版本号 不写的话默认为当前时间戳, 一般不写 scrapyd-deploy ubuntu-1 -p douban

注意

爬虫目录下不要放无关的py文件,放无关的py文件会导致发布失败,但是当爬虫发布成功后,会在当前目录生成一个setup.py文件,可以删除掉。

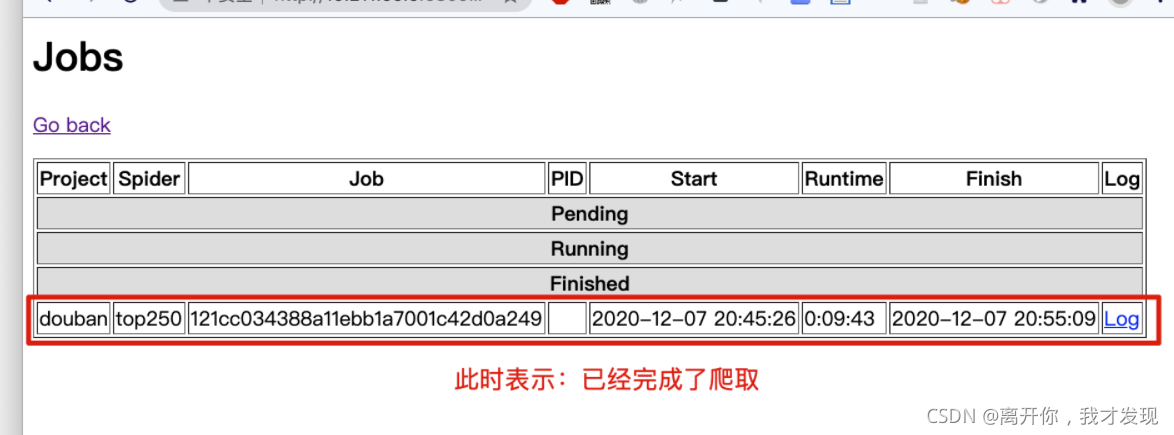

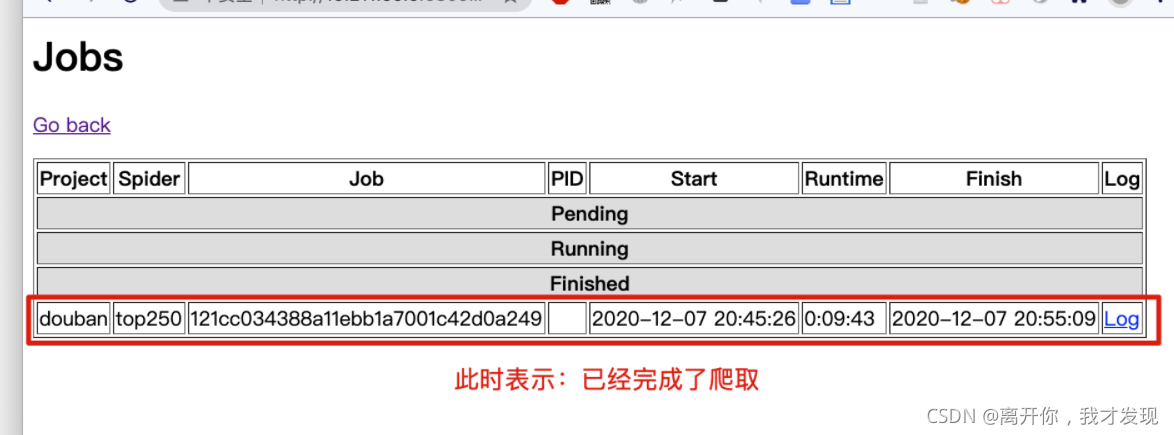

4.发送运行爬虫命令

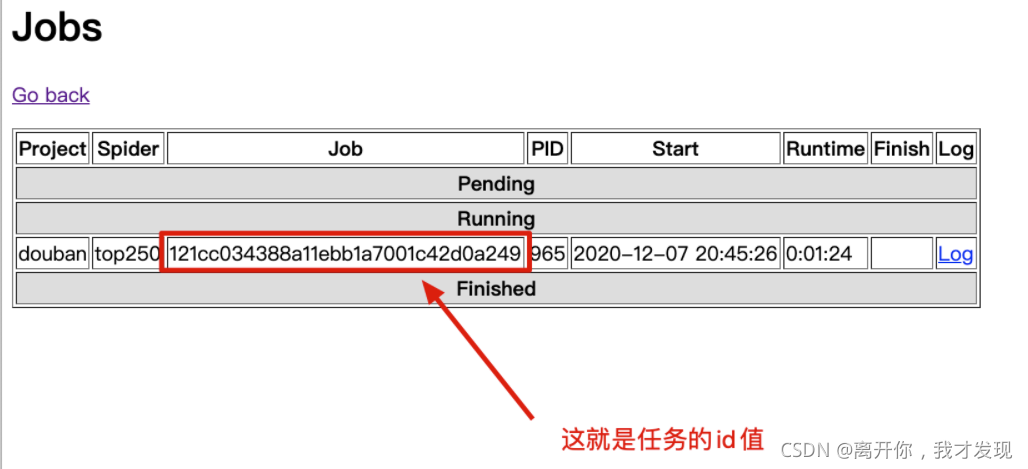

curl http://10.211.55.5:6800/schedule.json -d project=douban -d spider=top250

5.停止爬虫

curl http://ip:6800/cancel.json -d project=项目名 -d job=任务的id值

curl http://10.211.55.5:6800/cancel.json -d project=douban -d job=121cc034388a11ebb1a7001c42d0a249

注意

- 如果scrapy项目代码,修改了,只需要重新发布到scrapyd所在服务器即可

- 如果scrapy项目暂停了,可以再次通过

curl的方式发送命令让其“断点续爬”

Scrapy项目部署-图形化操作Gerapy

一,说明

Gerapy 是一款国人开发的爬虫管理软件(有中文界面)是一个管理爬虫项目的可视化工具,把项目部署到管理的操作全部变为交互式,实现批量部署,更方便控制、管理、实时查看结果。

gerapy和scrapyd的关系就是,我们可以通过gerapy中配置scrapyd后,不使用命令,直接通过图形化界面开启爬虫。

二,安装

命令 (安装在 爬虫代码 上传端)

pip install gerapy -i https://pypi.tuna.tsinghua.edu.cn/simple

测试

三,使用

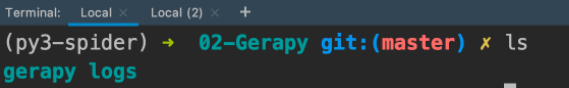

创建一个gerapy工作目录

gerapy init

生成文件夹,如下

创建splite 数据库, 存放部署scrapy 项目版本

gerapy migrate

创建成功之后,用tree命令,查看当前的文件列表

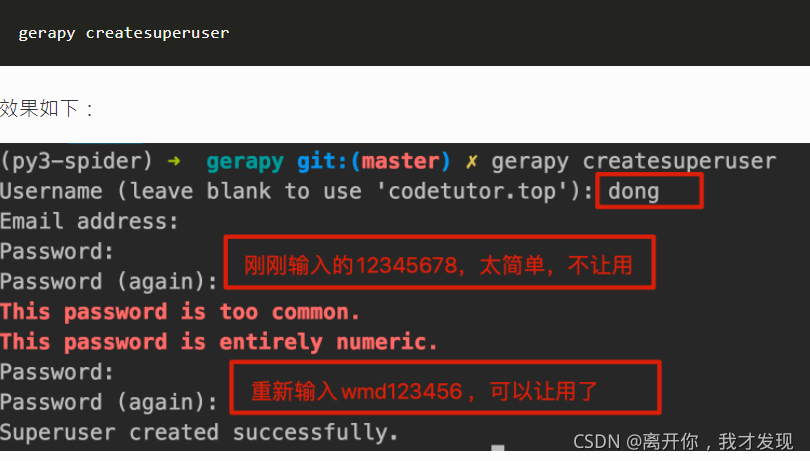

创建用户密码

启动服务

gerapy runserver

到此这篇关于快速部署 Scrapy项目 scrapyd的文章就介绍到这了,更多相关Scrapy项目 scrapyd内容请搜索hwidc以前的文章或继续浏览下面的相关文章希望大家以后多多支持hwidc!

【本文由:日本服务器 欢迎转载】